Você mal pode passar uma hora sem ler sobre IA generativa nos dias de hoje. Enquanto ainda estamos na fase embrionária do que alguns chamam de 'motor a vapor' da quarta revolução industrial, não há dúvida de que o 'GenAI' está se preparando para transformar praticamente todas as indústrias - desde finanças e saúde até direito e muito mais.

Aplicações legais voltadas para o usuário podem atrair a maior parte da atenção, mas as empresas que impulsionam essa revolução estão se beneficiando atualmente. Ainda neste mês, a fabricante de chips Nvidia brevemente se tornou a empresa mais valiosa do mundo, um gigante de US $ 3,3 trilhões impulsionado substancialmente pela demanda por poder computacional de IA.

Mas além das GPUs (unidades de processamento de gráficos), as empresas também precisam de infraestrutura para gerenciar o fluxo de dados - para armazenamento, processamento, treinamento, análise e, finalmente, desbloquear todo o potencial da IA.

Uma empresa que procura capitalizar isso é a Onehouse, uma startup californiana de três anos fundada por Vinoth Chandar, que criou o projeto de código aberto Apache Hudi enquanto era arquiteto de dados na Uber. Hudi traz os benefícios dos data warehouses para os data lakes, criando o que se tornou conhecido como 'data lakehouse', permitindo suporte para ações como indexação e realização de consultas em tempo real em grandes conjuntos de dados, sejam dados estruturados, não estruturados ou semi-estruturados.

Por exemplo, uma empresa de comércio eletrônico que coleta continuamente dados de clientes abrangendo pedidos, feedback e interações digitais relacionadas precisará de um sistema para ingerir todos esses dados e garantir que sejam mantidos atualizados, o que talvez ajude a recomendar produtos com base na atividade de um usuário. Hudi permite que os dados sejam ingeridos de várias fontes com latência mínima, com suporte para exclusão, atualização e inserção ('upsert'), o que é vital para tais casos de uso de dados em tempo real.

Onehouse constrói sobre isso com um data lakehouse totalmente gerenciado que ajuda as empresas a implantar o Hudi. Ou, como Chandar colocou, isso 'inicia a ingestão e a padronização de dados em formatos de dados abertos' que podem ser usados com quase todas as principais ferramentas nos ecossistemas de ciência de dados, IA e aprendizado de máquina.

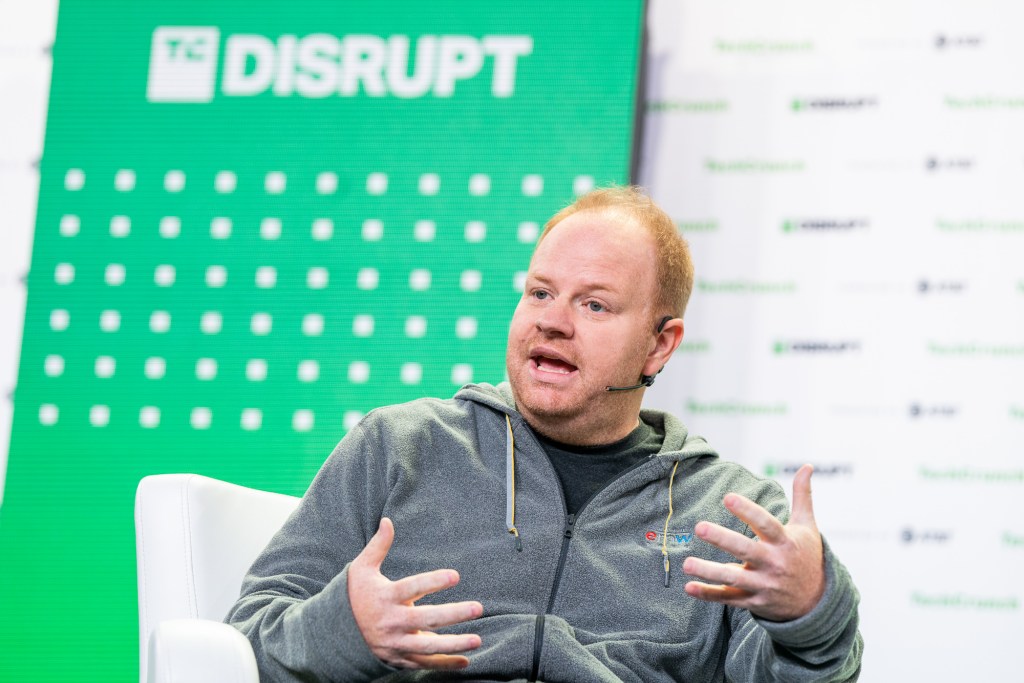

'Onehouse abstractiza a construção de infraestrutura de dados de baixo nível, ajudando empresas de IA a se concentrarem em seus modelos', disse Chandar ao TechCrunch.

Hoje, a Onehouse anunciou que arrecadou $35 milhões em uma rodada de financiamento da Série B à medida que lança dois novos produtos no mercado para melhorar o desempenho do Hudi e reduzir os custos de armazenamento e processamento em nuvem.

No (data) lakehouse

Chandar criou o Hudi como um projeto interno dentro da Uber em 2016, e desde que a empresa de transporte doou o projeto para a Apache Foundation em 2019, o Hudi foi adotado por empresas como Amazon, Disney e Walmart.

Chandar deixou a Uber em 2019, e, após um breve período na Confluent, fundou a Onehouse. A startup saiu do stealth em 2022 com $8 milhões em financiamento semente, e seguiu logo depois com uma rodada da Série A de $25 milhões. Ambas as rodadas foram co-lideradas por Greylock Partners e Addition.

Essas empresas de VC se uniram novamente para a continuação da Série B, embora desta vez David Sacks, da Craft Ventures, esteja liderando a rodada.

'O data lakehouse está se tornando rapidamente a arquitetura padrão para organizações que desejam centralizar seus dados para impulsionar novos serviços como análises em tempo real, ML preditivo e GenAI', disse o sócio da Craft Ventures, Michael Robinson, em comunicado.

Para contexto, data warehouses e data lakes são semelhantes na maneira como servem como um repositório central para agrupar dados. Mas eles o fazem de maneiras diferentes: um data warehouse é ideal para processar e consultar dados históricos e estruturados, enquanto os data lakes surgiram como uma alternativa mais flexível para armazenar grandes quantidades de dados brutos em seu formato original, com suporte para vários tipos de dados e consultas de alto desempenho.

Isso torna os data lakes ideais para cargas de trabalho de IA e aprendizado de máquina, pois é mais barato armazenar dados brutos pré-transformados, e ao mesmo tempo, tem suporte para consultas mais complexas porque os dados podem ser armazenados em sua forma original.

No entanto, o compromisso é um novo conjunto inteiro de complexidades de gerenciamento de dados, que podem piorar a qualidade dos dados, dada a vasta gama de tipos e formatos de dados. Isso é em parte o que o Hudi se propõe a resolver, trazendo algumas características-chave de data warehouses para data lakes, como transações ACID para suportar a integridade e confiabilidade dos dados, além de melhorar a gestão de metadados para conjuntos de dados mais diversos.

Sendo um projeto de código aberto, qualquer empresa pode implantar o Hudi. Uma rápida olhada nos logotipos no site da Onehouse revela alguns usuários impressionantes: AWS, Google, Tencent, Disney, Walmart, Bytedance, Uber e Huawei, para citar alguns. Mas o fato de empresas de grande nome utilizarem o Hudi internamente é indicativo do esforço e dos recursos necessários para construí-lo como parte de uma configuração de data lakehouse local.

'Embora o Hudi forneça funcionalidades ricas para ingerir, gerenciar e transformar dados, as empresas ainda têm que integrar cerca de meia dúzia de ferramentas de código aberto para alcançar seus objetivos de um data lakehouse de qualidade de produção', disse Chandar.

É por isso que a Onehouse oferece uma plataforma totalmente gerenciada e nativa da nuvem que ingere, transforma e otimiza os dados em uma fração do tempo.

'Os usuários podem colocar um data lakehouse de dados abertos em funcionamento em menos de uma hora, com ampla interoperabilidade com todos os principais serviços nativos em nuvem, data warehouses e motores de data lake', disse Chandar.

A empresa foi discreta ao nomear seus clientes comerciais, além do casal listado em estudos de caso, como o unicórnio indiano Apna.

'Como uma empresa jovem, não compartilhamos a lista completa de clientes comerciais da Onehouse publicamente neste momento', disse Chandar.

Com $35 milhões frescos no banco, a Onehouse agora está expandindo sua plataforma com uma ferramenta gratuita chamada Onehouse LakeView, que fornece visibilidade sobre a funcionalidade do lakehouse para insights sobre estatísticas de tabelas, tendências, tamanhos de arquivos, histórico de linha do tempo e muito mais. Isso se baseia nas métricas de observabilidade existentes fornecidas pelo projeto Hudi, proporcionando contexto adicionado em cargas de trabalho.

'Sem o LakeView, os usuários precisam passar muito tempo interpretando métricas e entender profundamente todo o stack para identificar problemas de desempenho ou ineficiências na configuração do pipeline', disse Chandar. 'O LakeView automatiza isso e fornece alertas por e-mail sobre tendências boas ou ruins, sinalizando as necessidades de gerenciamento de dados para melhorar o desempenho das consultas.'

Além disso, a Onehouse também está lançando um novo produto chamado Table Optimizer, um serviço em nuvem gerenciado que otimiza tabelas existentes para acelerar a ingestão e transformação de dados.

'Aberto e interoperável'

Não há como ignorar os numerosos outros jogadores de grande nome no espaço. Empresas como Databricks e Snowflake estão cada vez mais abraçando o paradigma do lakehouse: No início deste mês, a Databricks supostamente desembolsou $1 bilhão para adquirir uma empresa chamada Tabular, com o objetivo de criar um padrão de lakehouse comum.

A Onehouse entrou em um espaço quente com certeza, mas está esperando que seu foco em um sistema 'aberto e interoperável' que facilite evitar a dependência de fornecedores ajude a resistir ao teste do tempo. Essencialmente, está prometendo a capacidade de tornar uma única cópia de dados universalmente acessível de praticamente qualquer lugar, incluindo os serviços nativos da Databricks, Snowflake, Cloudera e AWS, sem precisar construir silos de dados separados em cada um.

Assim como a Nvidia no mundo das GPUs, não há como ignorar as oportunidades que aguardam qualquer empresa no espaço de gerenciamento de dados. Os dados são a pedra angular do desenvolvimento da IA, e não ter dados de boa qualidade suficientes é uma das principais razões pelas quais muitos projetos de IA falham. Mas mesmo quando os dados estão lá em abundância, as empresas ainda precisam da infraestrutura para ingerir, transformar e padronizar para torná-los úteis. Isso é promissor para a Onehouse e outros semelhantes a ela.

'Do lado da gestão e processamento de dados, acredito que dados de qualidade entregues por uma base sólida de infraestrutura de dados vão desempenhar um papel crucial em levar esses projetos de IA para casos de uso de produção do mundo real - para evitar problemas de dados ruins na entrada/saída', disse Chandar. 'Estamos começando a ver tal demanda em usuários de data lakehouse, enquanto eles lutam para dimensionar as necessidades de processamento e consultas de dados para construir essas novas aplicações de IA de escala empresarial.'